統計や機械学習において最も基本的な回帰分析手法は(通常)最小二乗法(OLS:Ordinary Least Squares)です。その中でも説明変数(x)が一つしかない単回帰分析は,Microsoft Excelの「近似曲線」機能etcで使用したことがある人は多いのではないでしょうか。本記事では,回帰分析の中で最も基礎的かつ単純な最小二乗法を用いた線形単回帰分析について説明します。

関連記事はこちら。

最小二乗法を用いた回帰分析ー②重回帰分析と非線形回帰分析ー【Pythonプログラム付】

統計や機械学習において最も基本的な回帰分析手法は(通常)最小二乗法(OLS:Ordinary Least Squares)です。その中でも説明変数(x)が一つしかない回帰分析を単回帰分析といいます。

しかし,現実にある様々な事象は複数...

大きい画面で表示したい方はこちらからご覧ください。

スライドの目次

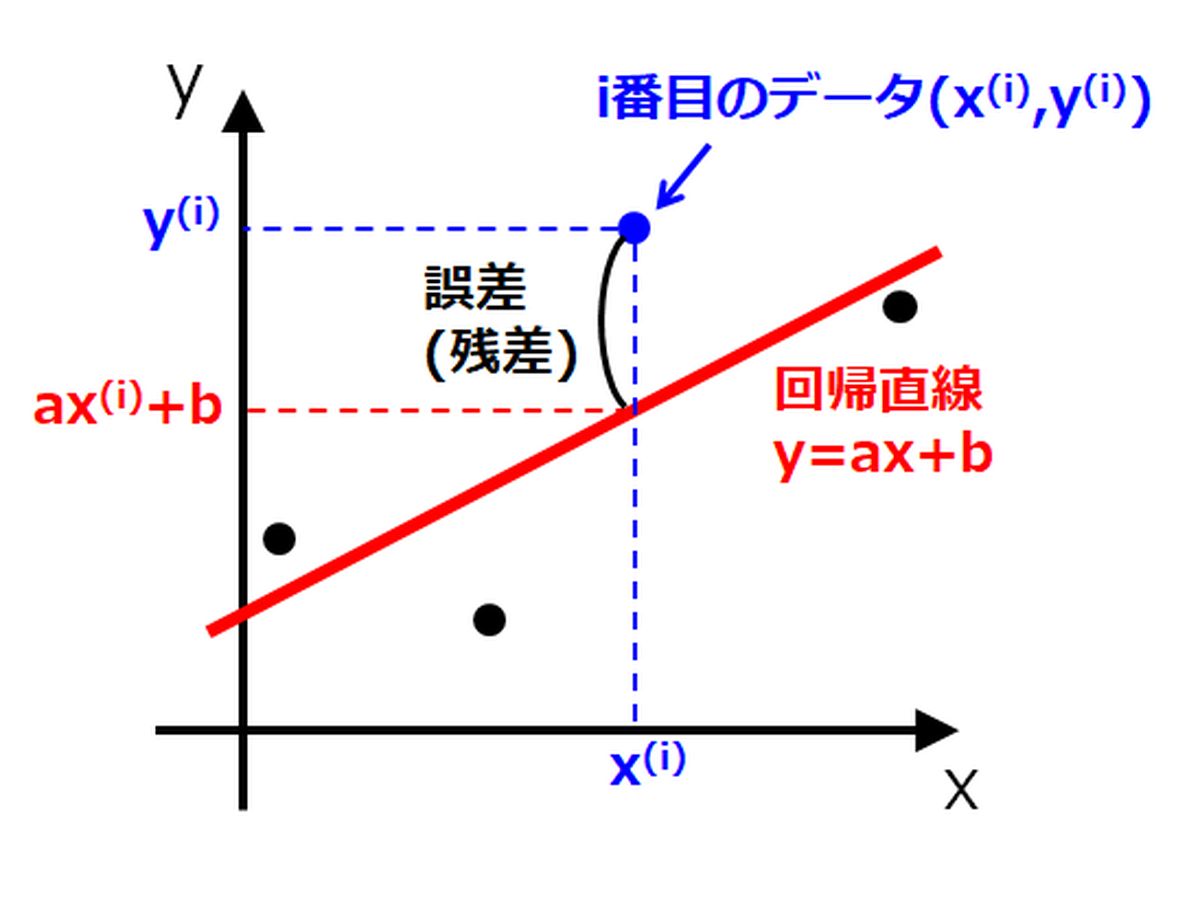

- 回帰分析とは?

- どのように回帰直線を引くか?

- 最小二乗法で扱う誤差関数

- 誤差関数は下に凸の2次関数

- 誤差関数を最小化する

- 行列で記述するほうがすっきり

- 行列表現での最小化

- なぜ誤差を2乗したのか?

参考文献

- 結城浩,数学ガールの秘密ノート/やさしい統計,SBクリエイティブ (2016)

- https://www.youtube.com/watch?v=Zz1sgYxrA-k

- C.M. ビショップ,パターン認識と機械学習 上, 丸善出版 (2012)

- 河村敏彦,製品開発のための実験計画法ーJMPによる応答曲面法・コンピュータ実験ー (2016)

- https://datachemeng.com/ordinaryleastsquares/

質問、コメント等ございましたら、下部のコメント欄,もしくはメールやTwitterよりご連絡ください。