ビッグデータを活用した Deep Learning が現在すさまじい発展を遂げていますが,以前まではサポートベクターマシン(Support Vector Machine)が主流でした。

サポートベクターマシン(Support Vector Machine)ー機械学習で非常に強力なクラス分類器!ー【Pythonプログラム付】

現在,AI技術の中心はビッグデータを活用した Deep Learning ですが,それ以前まではサポートベクターマシン(Support Vector Machine)が主流でした。工学分野では1万以下の少数データを用いる場面も多く,サポート...

工学分野ではデータの入手コストが高いことも多く,1万以下の少数データに対してサポートベクターマシンが活躍する機会はまだまだたくさんあります。本記事では,サポートベクターマシンを回帰分析手法に応用したサポートベクター回帰(Support Vector Regression)について解説します。

関連記事はこちら↓

リッジ回帰(Ridge Reression)とLASSOー過学習を抑制する正則化最小二乗法ー【Pythonプログラム付】

統計や機械学習において最も基本的な回帰分析手法は(通常)最小二乗法(OLS:Ordinary Least Squares)です。

しかし,データの量や性質によっては回帰係数がデータに過度に適合する過学習が生じる可能性があり,回帰曲線の...

大きい画面で表示したい方はこちらからご覧ください。

pythonによるサンプルプログラムはGitHubで公開しています。

スライドの目次

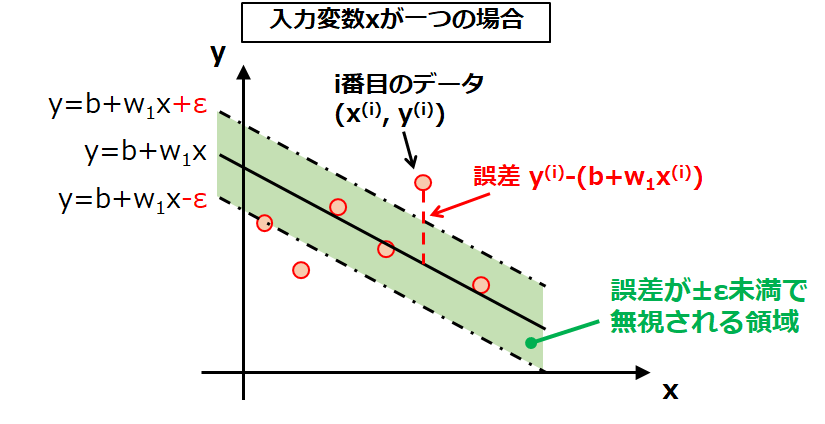

- サポートベクター回帰(SVR)とは

- 線形回帰の行列表現

- 最小二乗法の誤差関数

- サポートベクター回帰の誤差関数

- 損失関数のイメージ

- 損失関数の役割

- 誤差関数の最小化により係数ベクトルを求める

- 誤差関数の絶対値の場合分け

- スラック変数の導入による主問題の定義

- なぜスラック変数によりmax関数が消去できるか

- 主問題から双対問題へ

- ラグランジュの未定乗数法による変換

- 主変数と双対変数

- ラグランジュ関数の主変数による最小化

- 主変数を削除する

- (前ページの計算過程)

- 双対問題が完成

- サポートベクター回帰の回帰関数

- サポートベクターとは

- バイアスの計算

- 非線形写像

- カーネル関数による非線形写像

- カーネル関数の例

参考文献

- Alex et al., A tutorial on support vector regression, Statics and Computing, vol. 14, pp. 199–222 (2004)

- C.M. ビショップ,パターン認識と機械学習 下, 丸善出版 (2012)

- 竹内一郎・烏山昌幸,サポートベクトルマシン,講談社 (2015)

- https://datachemeng.com/supportvectorregression/

質問、コメント等ございましたら、下部のコメント欄,もしくはメールやTwitterよりご連絡ください。